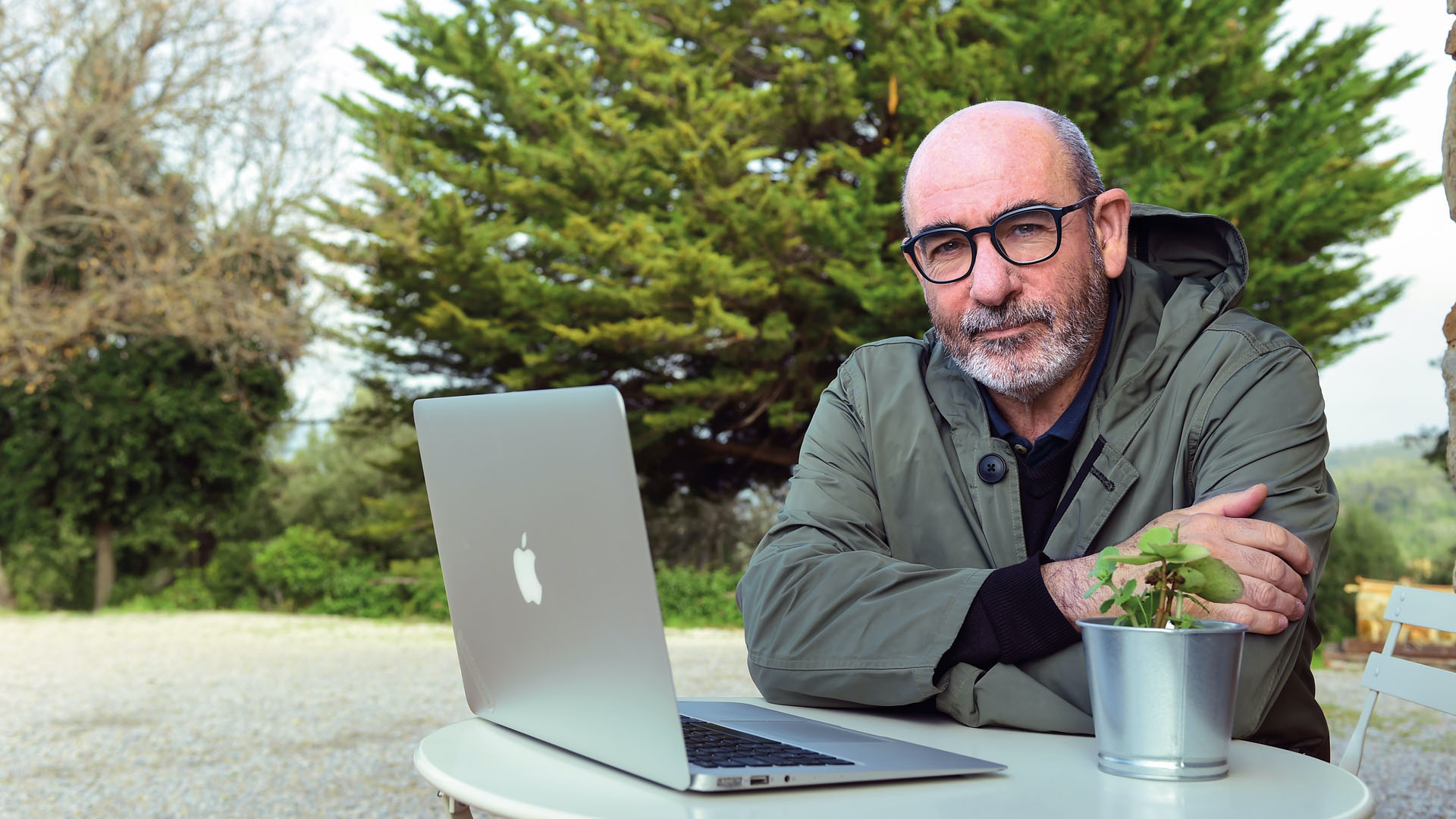

Sono questi alcuni degli innumerevoli interrogativi che ogni giorno il cesenate Andrea Sirotti Gaudenzi si è trovato ad affrontare analizzando i primi provvedimenti in materia di IA.

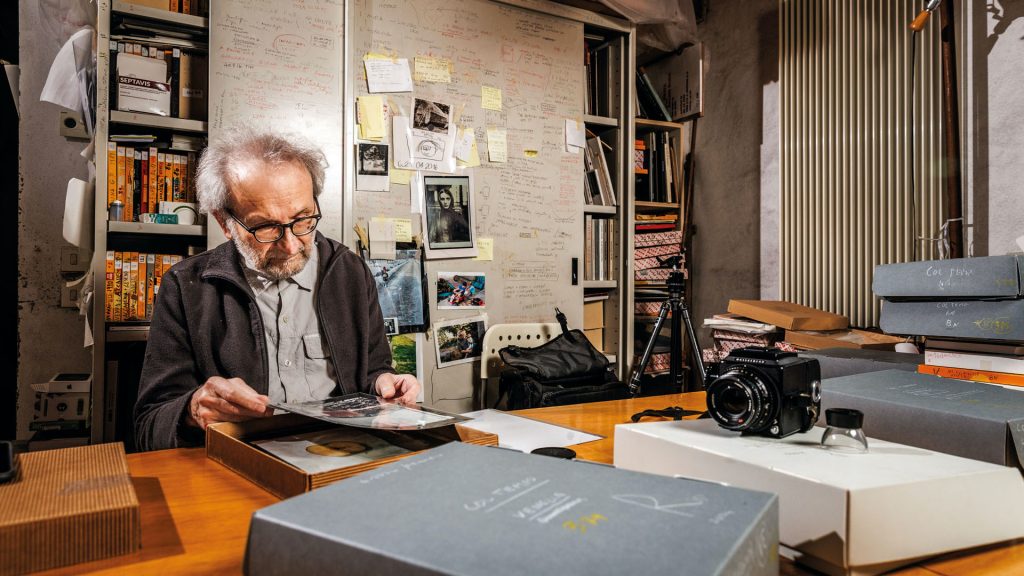

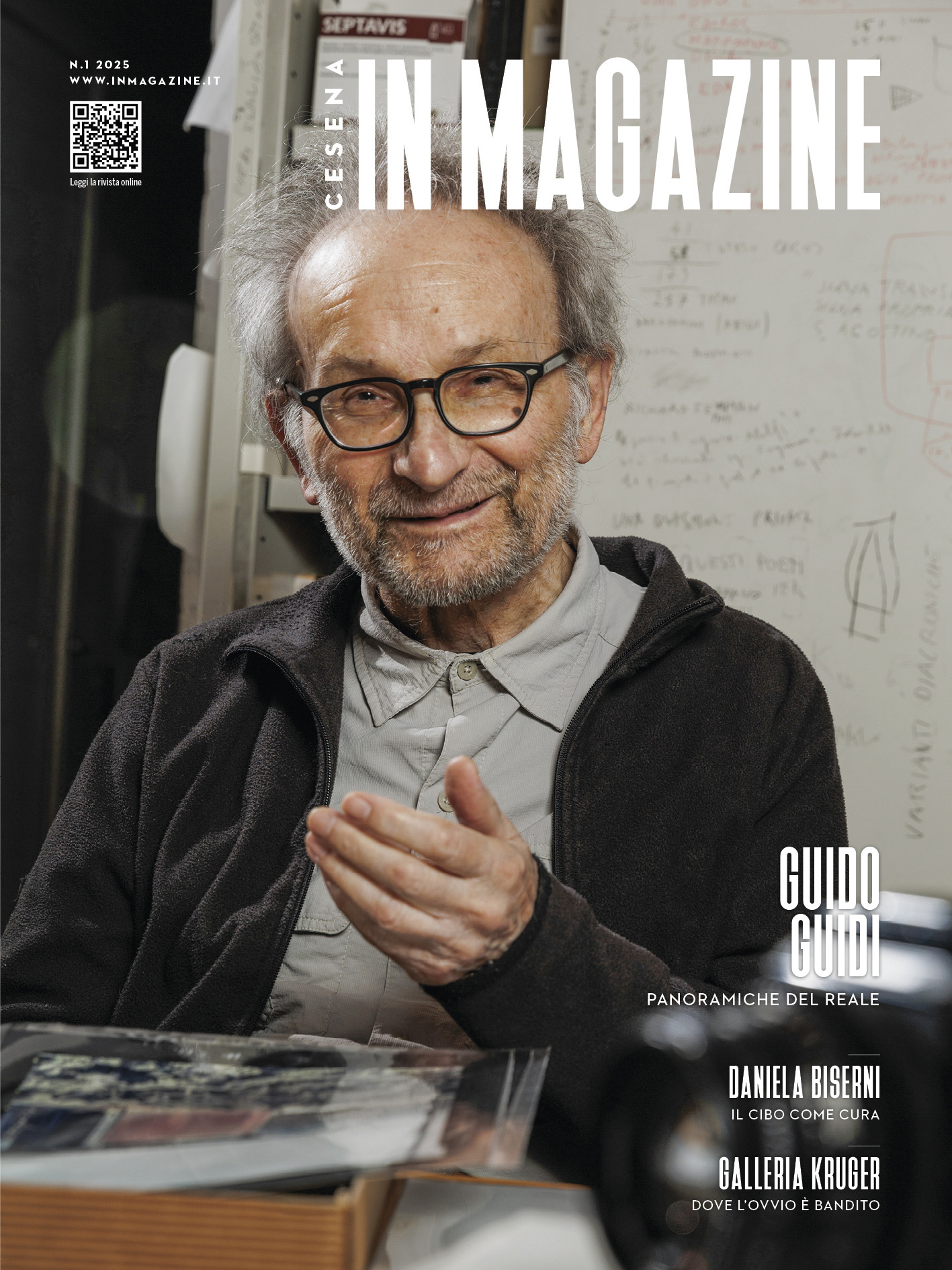

Andrea Sirotti Gaudenzi, classe 1972, è un avvocato cassazionista. Docente universitario presso vari atenei. Editorialista del gruppo Il Sole 24 Ore e patrocinatore davanti alla Corte europea dei Diritti dell’Uomo e alla Corte di Giustizia delle Comunità europee. Innanzi alle quali ha ottenuto alcuni significativi provvedimenti.

Studioso di diritto internazionale e della proprietà intellettuale, si sta dedicando all’approfondimento di temi cruciali legati all’interazione tra Intelligenza Artificiale (IA) e privacy. Analizzando anche le implicazioni etiche dell’IA in relazione alla tutela dei dati personali. All’applicazione del GDPR (Regolamento generale sulla protezione dei dati). E alle norme dedicate a tecnologie avanzate, tra cui le biotecnologie.

La sua vita si snoda tra Cesena, la città di origine della famiglia di Andrea Sirotti Gaudenzi, dove vive con la moglie Clara e il figlio Edoardo, per passare a Milano dove ha l’altro suo studio. E a Roma dove svolge attività di docenza presso il Master di informatica giuridica dell’Università La Sapienza, il Consorzio universitario Humanitas e l’Accademia universitaria degli studi giuridici europea. Di cui è stato recentemente nominato senatore accademico.

Sempre più di frequente si parla dell’Intelligenza Artificiale e l’attenzione per essa è cresciuta in maniera esponenziale anche nell’ambito del diritto. Eppure secondo Andrea Sirotti Gaudenzi siamo già in ritardo. “L’Intelligenza Artificiale è l’abilità di una macchina di mostrare capacità umane quali il ragionamento, l’apprendimento, la pianificazione e la creatività.

L’IA potrebbe essere definita una general purpose technology, ovvero una di quelle tecnologie capaci di caratterizzarsi per la loro pervasività e di condizionare pesantemente il percorso dell’umanità. Già nel 1950 Alan Turing si chiedeva: ‘Can machines think?’, ‘Le macchine possono pensare?’. “L’intelligenza artificiale,” spiega il giurista cesenate, “ha avuto almeno vent’anni per addestrarsi nel modo migliore attraverso il mondo del web 2.0 e poi dei social.

Adesso che siamo passati all’era del web 5.0 non siamo ancora in grado di prevedere tutte le diverse e complesse implicazioni che l’IA potrà avere nella vita di tutti noi. Qualcuno sta cercando di teorizzare un riconoscimento (anche se limitato) di una ‘personalità’ a favore dei sistemi artificiali. Quasi come se l’IA potesse sviluppare sentimenti simili a quelli dell’uomo.

Oggi si ritiene che i sistemi più avanzati di intelligenza artificiale siano in grado di sviluppare qualcosa di simile all’autoconsapevolezza del sé. Il problema è anche di natura etica, quindi. Qualcuno ha già ipotizzato una soggettività giuridica di serie A (quella umana). E una di serie B da attribuire ai modelli più elaborati di Intelligenza Artificiale. Sotto certi aspetti, non siamo più nella fase dell’implementazione, ma nella fase del tentativo di sostituzione dell’uomo con la macchina, fenomeno cui stiamo assistendo nel mondo del lavoro.”

Per Andrea Sirotti Gaudenzi alcune professioni stanno già ‘facendo i conti’ con questo nuovo approccio. “Resta però fondamentale il contributo umano perché dall’IA è possibile ricavare delle informazioni senza conoscerne però chiaramente la fonte. Questo frullatore può determinare tutta una serie di problematiche fino a mettere in discussione alcuni contenuti e soprattutto gli autori di questi contenuti.

Una sorta di contraffazione spesso inconscia o non consapevole perché l’Intelligenza Artificiale è talmente abile da riuscire, sulla base degli algoritmi in virtù della quale è stata programmata e si è auto-alimentata, a costruire qualcosa di apparentemente nuovo. Ma che non è del tutto nuovo e che addirittura rischia anche di non essere completamente vero.

Il problema delle fonti è più che mai attuale. Anche il sistema più evoluto creato con l’intento di svilupparsi su fonti autorevoli e ‘certificate’ può essere ‘contaminato’ da fonti non certificate (come quelle presenti nel mondo social). Da cui può recuperare informazioni non sempre attendibili e verificate.

Entra in gioco in maniera decisiva l’intervento dell’uomo che prima di tutto deve essere controllore. Ad esempio nell’ambito della medicina, in cui l’Intelligenza Artificiale può dare un supporto al genio umano, ma dove è prioritario l’intervento dell’uomo nella verifica delle informazioni, delle procedure e nella cura e nel rapporto con il paziente.”

Andrea Sirotti Gaudenzi, amante della storia e della sua città (alla quale ha dedicato il testo L’Eccidio di Cesena. La più grande strage del Medioevo, che recentemente ha ottenuto alcuni riconoscimenti in ambito letterario), da buon ricercatore aggiunge al problema della modalità di recupero delle fonti da parte dell’IA anche quello della ricostruzione della verità.

“Dobbiamo renderci conto che l’Intelligenza Artificiale può sbagliare. Come sbagliano gli uomini, possono sbagliare anche i sistemi più evoluti. Addirittura accade che – elaborando informazioni reperite in rete – i sistemi generativi possano inventare informazioni verosimili, spacciandole per autentiche. Abbiamo sperimentato vari esempi nel mondo del diritto.

Se a un determinato programma si chiedono alcune sentenze, il sistema offre una serie di provvedimenti, che possono sembrare anche verosimili, ma che non sono stati mai stabiliti da alcun tribunale. Il problema è più ampio, perché queste nuove tecnologie contribuiscono a porre costanti dubbi sulla ricostruzione della vita quotidiana.

L’utilizzo massiccio di Intelligenza Artificiale generativa ha scombinato i parametri dell’informazione, ponendoci di fronte a dubbi costanti su ciò che è vero e ciò che è falso. Dobbiamo però ricordare,” continua, “che l’Intelligenza Artificiale, così come ogni altra tecnologia, non è né buona né cattiva. Il mondo dell’informatica, la rete Internet, l’Intelligenza Artificiale e ogni altro sviluppo tecnologico realizzato dall’uomo non rappresentano un pericolo, se utilizzati a favore dell’uomo stesso.

Il banco di prova è quello educativo. Se nelle scuole l’IA verrà utilizzata per copiare e incollare, allora vorrà dire che avremo fallito. Ma se la scuola insegnerà ai giovani come affrontare le questioni etiche e sociali legate alla tecnologia, preparandoli a fare scelte consapevoli e responsabili. Allora l’IA diventerà uno degli strumenti di studio utilizzabili per fare ricerche, ampliare le proprie conoscenze e alimentare la curiosità.”